Reachlab- Blog

Blog

News von ReachLab sowie Einblicke und Analysen zu aktuellen Themen aus dem Performance Marketing, Digital Analytics & E-Commcerce.

kürzlich aktualisiert

- Alle

- Digital Analytics

- SEA

- SEO

- Social Ads

SEO für JTL Shops – Ein Guide

Aktualisiert am

April 16, 2024

Du betreibst einen JTL-Shop und möchtest dich in den Suchergebnissen bestmöglich positionieren? Um das volle Potenzial deines JTL-Shopsystems auszuschöpfen, sind gezielte SEO-Maßnahmen erforderlich, damit dein Shop die oberen Ränge der organischen Suchergebnisse erreicht und von Kunden leicht gefunden...

Ladenbesuche als Conversions: P-Max für Filialisten

Aktualisiert am

April 10, 2024

In der heutigen Online-Shopping Welt, bieten Ladenbesucher-Conversions Filialisten eine Brücke zwischen den umfangreichen Möglichkeiten des digitalen Marketings, die Google Ads Werbern eröffnet, mit den Vorteilen des lokalen Handels in Filialen. Seit ihrer Einführung als Beta im Jahr 2018...

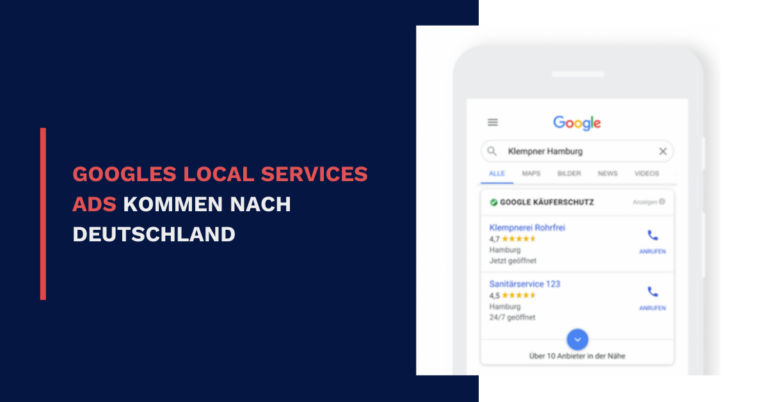

Googles Local Services Ads kommen nach Deutschland

Aktualisiert am

März 27, 2024

Update März 2024: Dieser Artikel wurde im März 2024 überarbeitet. Es wurden einige Details zu den Gebotsmodi hinzugefügt und Formulierungen angepasst. In den USA gingen sie bereits 2015 an den Start, seit ein paar Jahren sind die „Local...

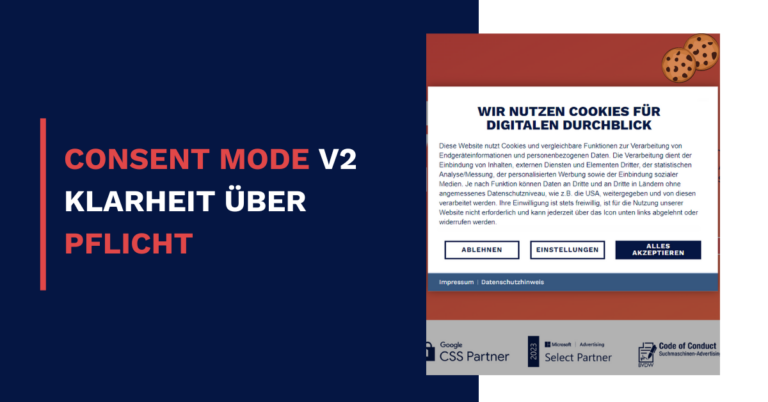

Consent Mode V2 – Klarheit über Pflicht

Aktualisiert am

März 21, 2024

Seit Jahresbeginn sorgt ein Thema bei Werbetreibenden für große Aufregung: Die bevorstehende Consent Mode „Pflicht“. Wilde Spekulationen und reißerische Headlines schüren Ängste und werfen Fragen auf. Erfahre in diesem Blogartikel, warum du trotzdem cool bleiben kannst und der...

Pin it to win it – von der Idee zum Kauf!

Aktualisiert am

März 20, 2024

Pinterest ist nicht wie die üblichen Social Media, sondern eine etwas andere Social Media Plattform. https://giphy.com/gifs/filmeditor-mean-girls-movie-3otPoBRKROJl9UbqMM Sie ist geprägt von Positivity und Freundlichkeit und dient als Inspirationsquelle für seine User. Hier werden Ideen für wichtige Ereignisse, wie die...

Alle Beiträge

Microsoft Advertising bzw. Bing Ads – lohnt sich der Google-Konkurrent?

Veröffentlicht am

Februar 20, 2024

Mehr als zehn Jahre ist es mittlerweile her, dass Microsoft die Suchmaschine Bing veröffentlichte. Der Gedanke dahinter war klar: Von dem gigantischen Kuchen, den das Suchaufkommen von Milliarden von Menschen...

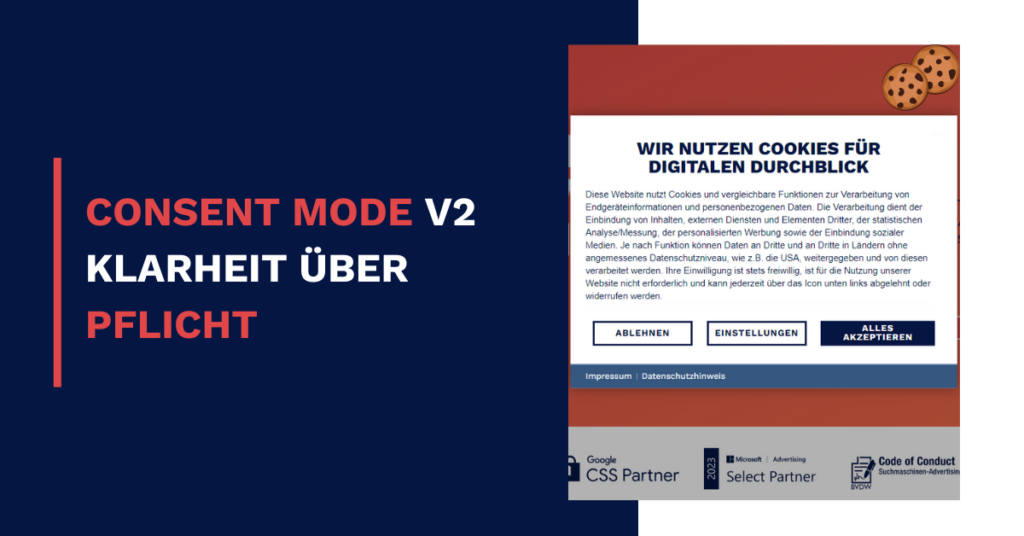

Consent Mode V2 – Klarheit über Pflicht

Veröffentlicht am

Februar 20, 2024

Seit Jahresbeginn sorgt ein Thema bei Werbetreibenden für große Aufregung: Die bevorstehende Consent Mode „Pflicht“. Wilde Spekulationen und reißerische Headlines schüren Ängste und werfen Fragen auf. Erfahre in diesem Blogartikel,...

GA4-Thresholding – Warum sehe ich meine Daten in GA4 nicht?

Veröffentlicht am

November 30, 2023

Du weißt, dass eine Landingpage ganz sicher Zugriffe verzeichnet, aber dein GA4-Bericht behauptet etwas anderes? Du hast dein Tracking schon unzählige Male überprüft und findest keinen einzigen Fehler? Dann kannst...

Google Analytics 4: So trackst Du den Internetanbieter

Veröffentlicht am

November 30, 2023

Seit dem 4. Februar 2020 fehlen in Google Analytics zwei Kennwerte, die über Jahre hinweg hilfreich für das Tracking-Setup waren: Der Internetanbieter (Internet Service Provider, im Folgenden ISP) sowie die...

Was macht ein starkes Creative aus? Kreative Elemente, die Aufmerksamkeit erregen

Veröffentlicht am

November 22, 2023

„Wieso sollten wir für Social Media anderes Werbematerial produzieren? Ist doch nur Geldverschwendung.“ Solche Aussagen hören wir immer wieder im Social Media Marketing.Die effektivste Art, Performance zu steigern und Umsätze...